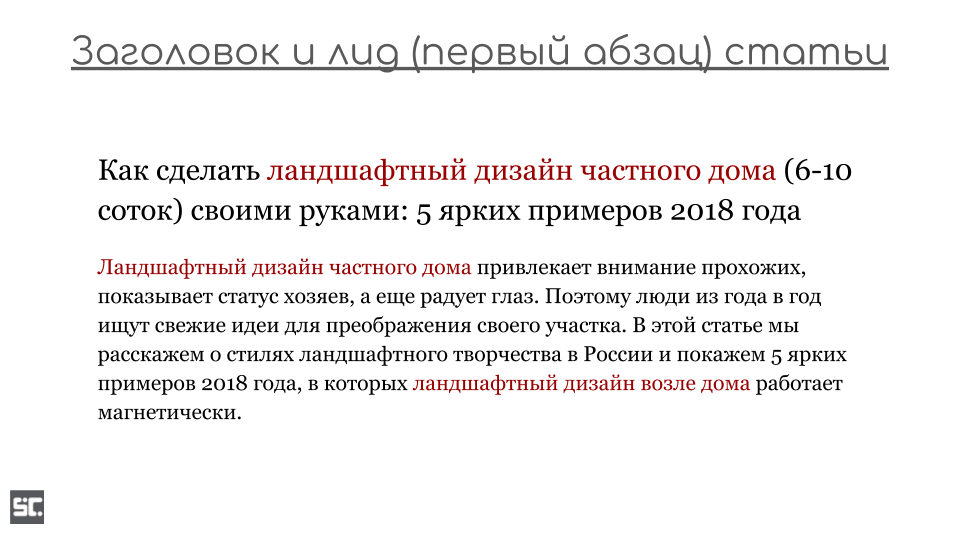

Парсинг ключевых слов, бесплатные и платные варианты

Содержание:

- Быстрый парсинг всех ключевых слов и объявлений для указанных доменов

- Определение перспективных ключевых фраз

- Пиксель Тулс

- Key Collector и СловоЕБ

- Варианты разбора

- Как поменять валюту в «Стиме» на доллары?

- Удаляем слова с нулевой частотностью

- Что можно делать с помощью SQL запросов

- 8 лайфхаков для ресторанного SMM

- Программы для подбора и фильтрации запросов

- Версии навигатора и системные требования для Андроид

- Слияние комментариев, форматирования и прочего

- Три способа записи Windows на флешку

- Десктопные и облачные парсеры

- Как узнать возможности чипсета?

- Парсеры Вордстат: какой выбрать?

- Способ 1. Парсим похожие вопросы с выдачи Google

- Подбор ключевых слов Яндекс.Директ в Вордстате

- Что такое семантическое ядро и почему оно так важно?

- Парсеры сайтов по способу доступа к интерфейсу

- Онлайн парсеры

- Зачем нужны парсеры

- Заключение

Быстрый парсинг всех ключевых слов и объявлений для указанных доменов

Создайте аккаунт в системе PromoPult (или авторизуйтесь, если у вас уже есть аккаунт). Откройте инструмент «Слова и объявления конкурентов». В блоке «Добавить задачу» укажите домены конкурентов или загрузите их с помощью XLSX-файла.

Блок профессиональных настроек пока не трогаем (мы еще разберем его).

В блоке «Поисковые системы» можно выбрать, в какой поисковой системе проверять домены. По умолчанию это Яндекс и Google. Также по умолчанию стоит галочка на пункте «Результаты на едином листе XLS» – в таблице с результатами данные по всем доменам будут сведены на одном листе.

Если вы проверяете небольшое количество доменов (до 5), можете ничего не менять здесь. Если же доменов больше, уберите галочку с этого пункта. В результатах парсинга под каждый домен будет создан отдельный лист – это удобнее для анализа большого количества данных.

Жмем «Запустить проверку». Система начнет парсинг доменов (в нашем случае на это ушло 5 минут). Если у вас нет времени ждать, вы можете закрыть страницу с инструментом – все работы проводятся в фоновом режиме.

После окончания проверки вам на почту придет уведомление:

Раскройте блок «Список задач» и кликните по пиктограмме Excel-таблицы, чтобы скачать отчет. Также здесь можно удалить отчет или запустить повторный парсинг.

В настройках парсинга есть возможность выбрать отображение отчета: отдельный лист для каждого домена или все на одном листе.

В зависимости от этой настройки отчет будет выглядеть по-разному.

Отчет по каждому домену на разных листах

В нашем примере мы получили именно такой отчет. При скачивании загружается архив с файлами в формате CSV:

Что содержит архив:

Файл с уникальными ключевиками для всех конкурентов. Для пяти доменов, которые мы добавляли в проверку, парсер собрал почти 32 000 ключей.

Общие результаты – данные по количеству объявлений на поиске Google и Яндекс. Для каждого домена данные указаны в разрезе регионов.

Технический файл, в котором указаны настройки парсинга.

Файлы с названиями доменов. Содержат ключевые слова конкурентов, заголовки и тексты объявлений. Данные указаны в разрезе поисковых систем и регионов. Например, вы можете посмотреть, какие объявления показывает конкурент в Яндексе в Санкт-Петербурге.

Обратите внимание! При парсинге объявления собираются из результатов поисковой выдачи в таком виде, в котором они отображаются. Кроме основного текста и заголовка могут собираться уточнения, быстрые ссылки и другие расширения (если они есть в объявлении)

Данные по доменам на одном листе

При таком способе отображения отчета загружается один XLSX-файл с четырьмя листами. Даже если вы парсите 50 доменов, листов в файле все равно будет четыре. Какие это листы:

«Результаты общие» – количество уникальных объявлений по всем доменам. Данные указаны в разрезе регионов и поисковых систем.

- «Слова и объявления». На этом листе собрана семантика по всем конкурентам и тексты объявлений. Данные указаны по каждому региону и поисковой системе. Если доменов много, работать с такой таблицей будет неудобно.

- «Слова». Собраны уникальные ключевики по всем доменам.

- «Исх. настройки». Указаны настройки парсинга.

Определение перспективных ключевых фраз

Когда денег на SEO мало (в случае с МСБ это почти всегда так), продвигаться по ядру из тысяч запросов не получится. Придется выбирать самые «жирные» из них, а остальные откладывать до лучших времен.

Один из способов — выбрать фразы, по которым страницы сайта находятся с 5 по 20 позицию в Google. По ним можно быстрее и с меньшими затратами выйти в ТОП-5. Ну и скачок позиций, скажем, с двенадцатой на третью даст намного больше трафика, чем с 100-й на 12-ю (узнать точный прирост трафика вы можете с помощью сценарного прогноза в Data Studio).

Позиции по ключевым фразам в Google доступны в Search Console. Для их выгрузки есть шаблон, описанный в Codingisforlosers.

Для выгрузки ключей из ТОП-20 необходимо:

- создать копию шаблона Quick Wins Keyword Finder (все шаблоны в статье закрыты от редактирования, просьба не запрашивать права доступа — просто создайте копию и используйте ее);

- установить дополнение для Google Sheets Search Analytics for Sheets (для настройки экспорта отчетов из Search Console в Google Sheets);

- иметь доступ к аккаунту в Search Console и накопленную статистику по запросам (хотя бы за пару месяцев).

Открываем шаблон и настраиваем выгрузку данных из Search Console (меню «Дополнения» / «Search Analytics for Sheets» / «Open Sidebar»).

Для автоматической выгрузки на вкладке «Requests»:

- в поле «Verified Site» выбираем сайт (после подтверждения доступа к аккаунту в появится список сайтов);

- в поле «Group By» выбираем «Query» и «Page» (то есть мы будем извлекать данные по запросам и страницам);

- в поле «Results Sheet» обязательно задаем «RAW Data», иначе шаблон работать не будет.

Нажимаем кнопку «Request Data». После экспорт данных на листе «Quick Wins» указаны запросы, страницы, количество кликов, показов, средний CTR и позиция за период. Эти ключи подходят для приоритетного продвижения.

Помимо автоматической выгрузки в шаблоне есть ручной режим. Перейдите на вкладку «MANUAL» и введите данные (ключи, URL и позиции). На вкладке «Quick Wins » будет выборка перспективных запросов.

Пиксель Тулс

Не совсем стандартный парсер, который ориентируется, в числе прочего, на поисковые подсказки. Присутствует функция перебора, которая позволяет повысить итоговую результативность работы парсера.

Производитель — знаменитая компания, давно специализирующая на создании специализированных инструментов для оптимизации и продвижения сайтов. Допускается устанавливать конкретный регион поиска для сбора и обработки информации.

Помимо платных сервисов существует обилие бесплатных услуг, с помощью которых можно провести анализ положения сайта и улучшить его характеристики.

Основные преимущества:

-

Разнообразие бесплатных услуг. Некоторые из этих услуг предоставляются другими компаниями за деньги.

-

Комплексный подход. В одном месте собрано множество инструментов для продвижения сайтов включая внешнюю и внутреннюю оптимизацию.

- Возможность посмотреть на одном экране множество показателей для более удобной аналитики.

Пиксель Тулс 7

Key Collector и СловоЕБ

Это комплексная десктопная программа, в которой есть буквально всё для работы с контекстной рекламой, в том числе сбор семантического ядра.

Чтобы сделать парсинг в Key Collector, добавляем фразы:

Запускаем парсинг. Рекомендация: выбирайте глубину 2. Так вы сразу получаете не только результаты парсинга, но и дополнительную выдачу по каждому из них.

Подробнее настройки описаны здесь.

Также Key Collector позволяет очистить семантическое ядро от «мусора», а именно:

- Ключевиков, которые содержат ненужные слова;

- Повторов слов;

- Стоп-слов (информационные запросы, города, в которых не действует предложение, «бесплатно», «дешево», субъективные определения и т.д.);

- Запросов с нулевой частотностью.

Есть бесплатный аналог Key Collector – СловоЕБ. Основное его ограничение – в источниках. Он работает только с левой и правой колонкой в Wordstat, Rambler.Adstat и поисковыми подсказками Яндекс и Google.

Для сравнения: Key Collector поддерживает всё вышеперечисленное, плюс Google Ads, подсказки Mail, Wordstat полностью и системы аналитики, установленные на сайте (Google Analytics, Яндекс.Метрика, LiveInternet).

Другие ограничения программы СловоЕБ:

- Проверяет частоту запросов только по Wordstat, а КК также по Yandex.Direct, Google.Ads, LiveInternet, Rambler.Adstat, APIShop.com;

- Оценивает конкурентность запросов для Яндекс и Google, в то время как в КК 4 формулы оценки KEI, которые можно менять вручную.

Однако этого функционала будет вполне достаточно, если у вас небольшой проект.

Варианты разбора

- Решать задачу в лоб, то есть анализировать посимвольно входящий поток и используя правила грамматики, строить АСД или сразу выполнять нужные нам операции над нужными нам компонентами. Из плюсов — этот вариант наиболее прост, если говорить об алгоритмике и наличии математической базы. Минусы — вероятность случайной ошибки близка к максимальной, поскольку у вас нет никаких формальных критериев того, все ли правила грамматики вы учли при построении парсера. Очень трудоёмкий. В общем случае, не слишком легко модифицируемый и не очень гибкий, особенно, если вы не имплементировали построение АСД. Даже при длительной работе парсера вы не можете быть уверены, что он работает абсолютно корректно. Из плюс-минусов. В этом варианте все зависит от прямоты ваших рук. Рассказывать об этом варианте подробно мы не будем.

- Используем регулярные выражения! Я не буду сейчас шутить на тему количества проблем и регулярных выражений, но в целом, способ хотя и доступный, но не слишком хороший. В случае сложной грамматики работа с регулярками превратится в ад кромешный, особенно если вы попытаетесь оптимизировать правила для увеличения скорости работы. В общем, если вы выбрали этот способ, мне остается только пожелать вам удачи. Регулярные выражения не для парсинга! И пусть меня не уверяют в обратном. Они предназначены для поиска и замены. Попытка использовать их для других вещей неизбежно оборачивается потерями. С ними мы либо существенно замедляем разбор, проходя по строке много раз, либо теряем мозговые клеточки, пытаясь измыслить способ удалить гланды через задний проход. Возможно, ситуацию чуть улучшит попытка скрестить этот способ с предыдущим. Возможно, нет. В общем, плюсы почти аналогичны прошлому варианту. Только еще нужно знание регулярных выражений, причем желательно не только знать как ими пользоваться, но и иметь представление, насколько быстро работает вариант, который вы используете. Из минусов тоже примерно то же, что и в предыдущем варианте, разве что менее трудоёмко.

- Воспользуемся кучей инструментов для парсинга BNF! Вот этот вариант уже более интересный. Во-первых, нам предлагается вариант типа lex-yacc или flex-bison, во вторых во многих языках можно найти нативные библиотеки для парсинга BNF. Ключевыми словами для поиска можно взять LL, LR, BNF. Смысл в том, что все они в какой-то форме принимают на вход вариацию BNF, а LL, LR, SLR и прочее — это конкретные алгоритмы, по которым работает парсер. Чаще всего конечному пользователю не особенно интересно, какой именно алгоритм использован, хотя они имеют определенные ограничения разбора грамматики (остановимся подробнее ниже) и могут иметь разное время работы (хотя большинство заявляют O(L), где L — длина потока символов). Из плюсов — стабильный инструментарий, внятная форма записи (БНФ), адекватные оценки времени работы и наличие записи БНФ для большинства современных языков (при желании можно найти для sql, python, json, cfg, yaml, html, csv и многих других). Из минусов — не всегда очевидный и удобный интерфейс инструментов, возможно, придется что-то написать на незнакомом вам ЯП, особенности понимания грамматики разными инструментами.

- Воспользуемся инструментами для парсинга PEG! Это тоже интересный вариант, плюс, здесь несколько побогаче с библиотеками, хотя они, как правило, уже несколько другой эпохи (PEG предложен Брайаном Фордом в 2004, в то время как корни BNF тянутся в 1980-е), то есть заметно моложе и хуже выглажены и проживают в основном на github. Из плюсов — быстро, просто, часто — нативно. Из минусов — сильно зависите от реализации. Пессимистичная оценка для PEG по спецификации вроде бы O(exp(L)) (другое дело, для создания такой грамматики придется сильно постараться). Сильно зависите от наличия/отсутствия библиотеки. Почему-то многие создатели библиотек PEG считают достаточными операции токенизации и поиска/замены, и никакого вам AST и даже привязки функций к элементам грамматики. Но в целом, тема перспективная.

Как поменять валюту в «Стиме» на доллары?

Удаляем слова с нулевой частотностью

Для целей контекстной рекламы слова с околонулевой частотностью не представляют интереса, поскольку по ним не будет показов. Такие слова лучше сразу удалить.

Для проверки частотности большого массива ключей в Click.ru есть парсер Wordstat. Он собирает частотности из левой колонки Wordstat. Он парсит частотность в любом регионе Яндекса и учитывает тип соответствия ключевых слов.

Как пользоваться инструментом

Перейдите на страницу инструмента. Добавьте запросы.

Выберите регион, по которому инструмент будет парсить частотности.

Укажите параметры сбора частотности. Инструмент собирает частотности по запросам в широком соответствии, фиксирует количество слов и морфологию, фиксирует порядок слов.

Для запуска задачи нажмите кнопку «Запустить проверку». Время сбора зависит от количества запросов, регионов и типов соответствия.

Отчет доступен в списке задач в формате XLSX.

В отчете указывается частотность запросов в разных типах соответствия. Удалите слова с нулевой и околонулевой частотностью.

Важно! Будьте внимательны с ключевыми словами, связанными с сезонными товарами/услугами. В Вордстате статистика собирается за последний месяц, поэтому если сейчас в вашей нише спад, частотность будет низкой

Детально об анализе частотности в Вордстате мы писали здесь. Также вам может помочь сервис Google Trends. Как с ним работать, тоже рассказывали.

После удаления «нулевок» можно приступать к группировке слов.

Что можно делать с помощью SQL запросов

8 лайфхаков для ресторанного SMM

Программы для подбора и фильтрации запросов

- Key Collector — по признанию многих оптимизаторов — это лучшая программа для составления семантического ядра;

- Словоеб — младший брат Key Collector;

- Allsubmitter — многофункциональная программа, при помощи которой можно подбирать ключевые слова;

- Магадан — парсер ключевых слов Яндекс.Директа;

- Key Hunter — поиск и парсинг открытых Яндекс.Метрик;

- Metrica Spy — поиск и парсинг открытых Яндекс.Метрик, обсуждение;

- МегаЛемма — софт для морфологической обработки массивов ключевых слов и дальнейшей группировки;

- YWSCheck — парсер Яндекс.Вордстат и Яндекс.Директ;

- Yandex Key Checker — программа проверки ключей в Яндексе на частоту и конкурентность;

- Букварикс — программа для быстрого подбора ключевых слов, обсуждение;

- YaLiPa — парсер прямого эфира Яндекс;

- Kolyan — парсер прямого эфира Яндекс;

Версии навигатора и системные требования для Андроид

Слияние комментариев, форматирования и прочего

Три способа записи Windows на флешку

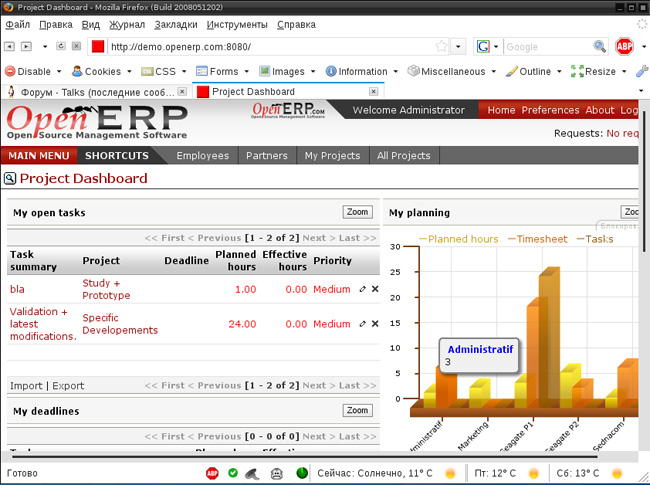

Десктопные и облачные парсеры

Облачные парсеры

Основное преимущество облачных парсеров — не нужно ничего скачивать и устанавливать на компьютер. Вся работа производится «в облаке», а вы только скачиваете результаты работы алгоритмов. У таких парсеров может быть веб-интерфейс и/или API (полезно, если вы хотите автоматизировать парсинг данных и делать его регулярно).

Например, вот англоязычные облачные парсеры:

- Import.io,

- Mozenda (доступна также десктопная версия парсера),

- Octoparce,

- ParseHub.

Из русскоязычных облачных парсеров можно привести такие:

- Xmldatafeed,

- Диггернаут,

- Catalogloader.

Любой из сервисов, приведенных выше, можно протестировать в бесплатной версии. Правда, этого достаточно только для того, чтобы оценить базовые возможности и познакомиться с функционалом. В бесплатной версии есть ограничения: либо по объему парсинга данных, либо по времени пользования сервисом.

Десктопные парсеры

Большинство десктопных парсеров разработаны под Windows — на macOS их необходимо запускать с виртуальных машин. Также некоторые парсеры имеют портативные версии — можно запускать с флешки или внешнего накопителя.

Популярные десктопные парсеры:

- ParserOK,

- Datacol,

- Screaming Frog, ComparseR, Netpeak Spider — об этих инструментах чуть позже поговорим подробнее.

Как узнать возможности чипсета?

Данные о спецификации тех или иных чипсетов можно посмотреть на официальных сайтах AMD или Intel. К примеру, чтобы получить информацию о чипсете HM76 (Intel) необходимо:

Шаг 1. Перейти в Google, ввести в поисковой строке «Intel HM76».

Переходим в Google, вводим в поисковой строке «Intel HM76»

Шаг 2. Перейти по первой ссылке, ведущей на сайт ark.intel.com. Там и будут указаны все спецификации необходимого чипсета.

Переходим по первой ссылке, ведущей на сайт ark.intel, читаем информацию о чипсете

Итого, узнать марку установленного чипсета можно и без разборки ПК или ноутбука.

Парсеры Вордстат: какой выбрать?

Парсер — программа для автоматического сбора и обработка синтаксической информации во всемирной паутине. Самостоятельно анализировать ключевые слова запросы из Wordstat онлайн бывает сложно и неудобно. Первое правило любого специалиста — автоматизировать все, что можно и пользоваться готовым результатом. Для автоматического парсинга используются программы парсеры или сервис онлайн.

Главные выгоды автоматизации:

-

Снижение негативного влияния человеческого фактора. Выполнение рутинных действий сопряжено с ошибками, которые бывают даже у самых внимательных работников.

- Повышение эффективности. Хороший парсер обрабатывает огромное количество информации. Ни один человек не в состоянии самостоятельно выполнить подобную работу.

Автор статьи Дмитрий Интернет-маркетолог Полезная информация: в рунете встречаются разнообразные парсеры Wordstat онлайн. Пользоваться лучше проверенным программным обеспечением. Неизвестный софт с закрытым исходным кодом может работать некорректно, а то и вовсе собирать конфиденциальную информацию.

Ниже рассмотрены самые популярные парсеры Яндекс Вордстат. Рассмотрим известные программы и сервисы, а так же их плюсы и минусы.

Способ 1. Парсим похожие вопросы с выдачи Google

Введите в поиске Google любой информационный запрос. Например, в формате «как сделать…». В выдаче, скорее всего, кроме обычных сниппетов появится блок с похожими вопросами. Выглядит он вот так:

При клике по любому вопросу он раскрывается, отображается ответ (релевантный фрагмент контента) и ссылка на страницу, откуда этот ответ взят.

Также при раскрытии одного вопроса ниже появляются новые вопросы. Соответственно, чем больше вопросов вы раскроете, тем больше появится новых вопросов и ответов.

Что с этим делать?

«Похожие вопросы» — тот самый источник низкочастотных запросов, о котором могут не догадываться ваши конкуренты. Алгоритм работы такой:

- Открыть как можно больше вопросов (чтобы подгрузились новые и список был больше).

- Собрать вопросы в файл.

- Оптимизировать под них существующий контент на сайте или создать новые страницы.

Собрать вопросы можно вручную: раскрыть как можно больше, выделить их, затем скопировать и вставить в Google Таблицы или Excel. Минус такого способа скопируется лишний контент (ссылки и картинки).

Такую табличку нужно будет почистить от ненужного контента, чтобы остались только вопросы.

Но проще спарсить вопросы с помощью Xpath-парсера. Если вы не знакомы с Xpath, это не проблема. Это специальный язык запросов, с помощью которых можно извлечь содержимое любого html или xml документа. Для парсинга вопросов, на самом деле, о Xpath больше знать ничего и не нужно. Но если хотите узнать больше о синтаксисе языка и возможностях использования, почитайте документацию.

Сбор запросов с помощью Xpath-парсера

Откройте все вопросы, которые показываются в блоке изначально, а затем откройте новые вопросы, которые появились после открытия первых.

Не ограничивайте себя: откройте максимальное количество вопросов – чем больше, тем лучше. Удобнее всего начать с нижних вопросов и открывать их снизу вверх.

4. Кликните по иконке Scraper’а, в меню расширения выберите пункт «Scrape similar…».

5. Откроется окно парсера. В блоке Selector выберите Xpath в выпадающем списке, а в поле справа введите «//g-accordion-expander».

Обратите также внимание на блок «Column». Заполните его так, как показано на скриншоте:

Затем нажмите кнопку «Scrape».

В правой области окна появятся данные, которые собрал парсер. Теперь их нужно привести в удобный для использования вид. Если мы их в таком виде вставим в Excel, работать с ними будет достаточно непросто:

С таким текстом можно справиться с помощью формул: разбить текст на колонки и затем взять только вопросы.

Но нет смысла ломать голову, так как есть готовое решение. Для этого нужны Google Таблицы и этот шаблон. Откройте шаблон и нажмите «Файл → Создать копию».

Откройте копию и перейдите на лист «Google Questions and Answers».

Дальше последовательность действий такая:

-

В интерфейсе парсера (Scraper) кликаем по кнопке «Copy to clipboard».

-

Переходим в таблицу с шаблоном и устанавливаем курсор в ячейку А10 (с содержимым «Text»).

-

Нажимаем сочетание клавиш Ctrl+Shift+V. Собранные парсером значения будут вставлены в первый столбец таблицы, а в остальных столбцах формулы разобьют сплошной текст на фрагменты (вопрос, ответ и другие).

-

Открываем лист «Clean Data» – в столбце «Question» будет список вопросов, очищенный от дубликатов. Копируем список и вставляем его в отдельную таблицу или текстовый файл.

Обратите внимание! После такой процедуры у вас на руках не только список перспективных НЧ-запросов, но и практически готовый контент-план для статей

Подбор ключевых слов Яндекс.Директ в Вордстате

Подбор ключевых слов для Яндекс Директ осуществляется на основе статистики запросов поисковой системы Яндекс. Эта статистика доступна в сервисе Яндекс.Вордстат — https://wordstat.yandex.ru/. Здесь можно найти статистику запросов за последний месяц или любой другой промежуток времени. Посмотреть статистику ключевых слов в отдельных регионах и городах, а также по типам устройств.

Рассмотрим по шагам, как работать с сервисом.

Шаг 1. В поисковую строку введите основной вид деятельности Вашего бизнеса. Например, если компания занимается малоэтажным строительством, то нужно ввести или .

Подбор ключевиков по регионам

Шаг 2. Чтобы посмотреть статистику по региону, в котором Вы работаете — выберите «Все регионы», отметьте свой регион или город, а затем подтвердите свой выбор, нажав «Выбрать».

Вы увидите подробную статистику по ключевым запросам за последний месяц в нашем регионе. Остаётся собрать ключевые слова. Для этого мы рекомендуем использовать плагин Yandex Wordstat Helper для бразуера. Он поможет быстро выбирать нужные ключевые слова для нашей рекламной кампании и рядом с запросами, у Вас будут отображаться плюсики. Нажимая на «плюсик» рядом с ключевым слово, Вы даёте указание плагину запомнить его.

Пройдитесь по нескольким страницам статистики и отберите ключевые слова, по которым Вы бы хотели рекламироваться, при этом отсеивая ненужные: или . Такие запросы вводят не клиенты, а соискатель рабочего места.

После того, как Вы отобрали необходимый перечень ключевых слов, нажмите кнопочку «Копировать в буфер обмена», а затем вставьте их в экселевскую таблицу.

Задайте вопрос себе и своим сотрудникам, как Вас ещё могут искать пользователи в сети? Проведите мозговой штурм. Ведь сколько людей, столько и мнений. Проанализируйте, какие синонимы могут быть у тех ключевых слов, которые Вы уже отобрали. Например, кто-то может искать или , а ведь они тоже могут являться Вашими клиентами. Следует учесть и то, что человек вообще может не упомянуть какое-то из ключевых слов в запросе и ввести скажем , тем самым также подразумевая строительство.

Здесь, мы специально выбрали строительную тематику, чтобы наглядно показать, насколько различными могут быть запросы клиентов. Да, в некоторых случаях, они могут ограничиться несколькими сотнями, а в других и 50000 будет казаться мало. Именно, поэтому так важен правильный подбор ключевых слов для Яндекс Директ.

Как проверить частотность ключевых слов

Шаг 3. Перед использованием собранных слов, их нужно очистить от мусорных запросов или запросов пустышек. «Пустышки» — запросы, которые используются в составе других запросов, но не используются отдельно.

Берём фразу . По данным сервиса она используется 219 376 раз в месяц.

Проверяем фразу, для этого ставим её в кавычки и перед каждым слов без пробела пишем восклицательный знак . И видим, что реальных запросов гораздо меньше.

Это так называемая проверка частотности ключевых слов. Минус подхода в том, что каждый ключевик нужно проверять отдельно. Если у вас небольшой объём семантики, до 100 ключевых слов, то можно сделать это вручную. В остальных случаях рекомендуем использовать онлайн-сервисы для парсинга, о которых мы расскажем ниже.

Шаг 4. Все отобранные нами ключевые слова, Вы можете использовать при создании своих рекламных объявлений. Для одного рекламного объявления можно задать до 200 ключевых слов по которым оно будет показываться.

Подробнее: Настройка рекламы Яндекс.Директ

Что такое семантическое ядро и почему оно так важно?

Перечень ключевых слов и фраз, которые характеризуют направление и тематику сайта, называют семантическим ядром. Оно позволяет понять, пользуется ли спросом информация, товар, услуга, и выстроить грамотную структуру ресурса.

Термин «семантическое ядро» встречается часто. Что это такое? Поговорим о механизме работы поисковой системы. Мы вводим запрос (ключевое слово) и получаем перечень страниц, максимально релевантных нашему запросу и оптимизированных под него. Семантическим ядром считается список всех ключей, используемых для продвижения сайта.

Вам обязательно нужно знать и понимать, какие сведения и по каким запросам человек может найти на веб-ресурсе. Если вы не знаете этого, востребованным сайт никогда не станет. То есть SEO-продвижение невозможно без формирования семантического ядра.

Веб-сайт должен привлекать всю целевую аудиторию (ЦА). Для этого требуется:

- сбор полного семантического ядра. Помните, что на один запрос не делают одну страницу;

- кластеризация запросов. После сбора всех ключевых слов их нужно объединить в группы. В них может быть как 5, так и 25 ключей. Каждая группа предназначена для решения одной задачи;

- определение посадочной страницы. Одна страница — на одну группу. На сайте не должно быть двух страниц, решающих одну задачу.

Если вы заинтересованы в нормальном SEO-продвижении своего ресурса, соберите все возможные ключи. Возьмем сайт строительной компании. При выборе запросов мы понимаем, что жилье можно разбить по типам: дом, таунхаус, квартира и т. д. Соответственно подбираются следующие ключевые запросы: купить дом, купить квартиру, купить таунхаус, купить дом с ремонтом и пр.

Итак, мы разбили запросы на все способы и типы. Сейчас наша задача — разместить информацию. Необязательно помещать всё в меню веб-сайта. Лучше распределите данные по страницам разделов и подразделов, создайте блок фильтров. Так вы раскидаете все запросы по сайту и получите дополнительный трафик.

Поэтапное формирование семантического ядра выглядит так:

- Сбор ключевых запросов из многочисленных источников.

- Очистка ядра от неподходящих запросов.

- Объединение и группировка запросов.

- Формирование структуры сайта под данное ядро.

Залог качественного SEO-продвижения сайта заключается в грамотном формировании семантического ядра. Оно несет смысловую нагрузку вашего ресурса. Если человек по запросу не может получить полные (релевантные) сведения о вашем сайте, придется с ним (с сайтом) поработать.

Формирование качественного семантического ядра — долгий процесс. Кто-то предпочитает сбор семантики вручную, но большинство веб-студий делают это автоматизировано, используя специальные сервисы. Как подобрать запросы, что брать за основу? Поговорим об основных источниках ключевых слов.

В первую очередь нужно проанализировать информацию, товары или услуги, которые уже размещены или скоро появятся на сайте. Это — самое главное при работе с семантическим ядром. Ваша задача — максимально глубоко проанализировать проект и понять специфику ниши. У многих веб-специалистов нет возможности полностью изучить чужой бизнес, а потому в этом вопросе непременно нужно взаимодействовать с клиентом. Так, например, вы можете согласовать весь перечень поисковых фраз.

Яндекс-статистика запросов в поисковиках — прекрасное решение для оптимизаторов, позволяющее узнать, что пользователи ищут в Интернете. Всё, что вам нужно сделать — зайти на сервис wordstat.yandex.ru. Подобный инструмент есть и у Google: частота запросов www.google.ru/adwords/. Сервисы предназначены для использования контекстной рекламы, однако и для SEO-оптимизации тоже подходят.

Статистика сайта — отличный источник ключевых слов. Её также необходимо тщательно анализировать, особенно если у сайта уже есть хороший трафик. Накопленные данные позволяют оценить запросы и трафик поведения пользователей на странице (число просмотров, проведенное время, количество отказов).

Чтобы легко и быстро создать качественную структуру сайта, нужно проанализировать веб-ресурсы конкурентов. Необходимо лишь найти нескольких лидеров в вашем сегменте, у которых SEO-структура сформирована грамотно.

Далее есть несколько вариантов:

- анализ видимости конкурентов в поисковиках и получение списка их ключевых слов. Формирование семантического ядра на основе данных запросов или дополнение своего отсутствующими;

- сбор лучших решений из структуры нескольких сайтов конкурентов и создание своей идеальной.

Парсеры сайтов по способу доступа к интерфейсу

Облачные парсеры

Облачные сервисы не требуют установки на ПК. Все данные хранятся на серверах разработчиков, вы скачиваете только результат парсинга. Доступ к программному обеспечению осуществляется через веб-интерфейс или по API.

Примеры облачных парсеров с англоязычным интерфейсом:

- http://import.io/,

- Mozenda (есть также ПО для установки на компьютер),

- Octoparce,

- ParseHub.

Примеры облачных парсеров с русскоязычным интерфейсом:

- Xmldatafeed,

- Диггернаут,

- Catalogloader.

У всех сервисов есть бесплатная версия, которая ограничена или периодом использования, или количеством страниц для сканирования.

Программы-парсеры

ПO для парсинга устанавливается на компьютер. В подавляющем большинстве случаев такие парсеры совместимы с ОС Windows. Обладателям mac OS можно запускать их с виртуальных машин. Некоторые программы могут работать со съемных носителей.

Примеры парсеров-программ:

- ParserOK,

- Datacol,

- SEO-парсеры — Screaming Frog, ComparseR, Netpeak Spider и другие.

Онлайн парсеры

Подобные сервисы появились относительно недавно. Их преимущество – не нужно скачивать и устанавливать локально программные комплексы. Это экономит время, но сказывается на точности выборки КС. Причина – онлайн-парсеры не работают напрямую с базами данных Wordstat, а периодически скачивают их. Недостаток – не все запросы попадают в информационное поле сервиса.

Букварикс онлайн версия

Первым онлайн-сервисом с расширенными возможностями для SEO-оптимизаторов стал «Букварикс». До недавнего времени его использование было полностью бесплатным. Но с вводом нового функционала появилась платная подписка. Ее преимущества – фильтрация по частотности, количеству символов и слов. Есть ограничения для незарегистрированных пользователей. Но эта процедура бесплатная, возможна авторизация через социальные сети.

Особенности работы с «Букварикс»:

- максимальное количество поисковых фраз – 300 для платной версии;

- возможность скачивания отчета в формате .csv;

- группировка словоформ;

- дополнительные инструменты – анализ доменов, нормализатор, дубликатор и комбинатор слов.

Сервис значительно уступает по возможностям аналогичным программам, но прост в использовании. Рекомендован для начинающих оптимизаторов.

Зачем нужны парсеры

Парсер — это программа, сервис или скрипт, который собирает данные с указанных веб-ресурсов, анализирует их и выдает в нужном формате.

С помощью парсеров можно делать много полезных задач:

Для справки. Есть еще серый парсинг. Сюда относится скачивание контента конкурентов или сайтов целиком. Или сбор контактных данных с агрегаторов и сервисов по типу Яндекс.Карт или 2Гис (для спам-рассылок и звонков). Но мы будем говорить только о белом парсинге, из-за которого у вас не будет проблем.

Где взять парсер под свои задачи

Есть несколько вариантов:

- Оптимальный — если в штате есть программист (а еще лучше — несколько программистов). Поставьте задачу, опишите требования и получите готовый инструмент, заточенный конкретно под ваши задачи. Инструмент можно будет донастраивать и улучшать при необходимости.

- Воспользоваться готовыми облачными парсерами (есть как бесплатные, так и платные сервисы).

- Десктопные парсеры — как правило, программы с мощным функционалом и возможностью гибкой настройки. Но почти все — платные.

- Заказать разработку парсера «под себя» у компаний, специализирующихся на разработке (этот вариант явно не для желающих сэкономить).

Первый вариант подойдет далеко не всем, а последний вариант может оказаться слишком дорогим.

Что касается готовых решений, их достаточно много, и если вы раньше не сталкивались с парсингом, может быть сложно выбрать. Чтобы упростить выбор, мы сделали подборку самых популярных и удобных парсеров.

Законно ли парсить данные?

В законодательстве РФ нет запрета на сбор открытой информации в интернете. Право свободно искать и распространять информацию любым законным способом закреплено в четвертом пункте 29 статьи Конституции.

Допустим, вам нужно спарсить цены с сайта конкурента. Эта информация есть в открытом доступе, вы можете сами зайти на сайт, посмотреть и вручную записать цену каждого товара. А с помощью парсинга вы делаете фактически то же самое, только автоматизированно.

Заключение

Вот мы и рассмотрели, как подключить монитор к ноутбуку. Надеюсь, что эта информация оказалась для вас полезной.